Chatbot oder Therapeutin? Die besondere Gesprächskonstellation in “Eliza”

Bereits in den 1960ern hat der Informatiker Joseph Weizenbaum ein Computerprogramm namens ELIZA geschrieben, das als eine Art Chatprogramm verschiedene Gesprächspartner – wie z.B. die berühmt gewordene Rolle der Psychotherapeutin – simulieren sollte. Es schnappte einzelne Wörter der Eingabe auf und suchte nach passenden Überbegriffen, mit denen es den Nutzer*innen allgemeinere Nachfragen stellen konnte. Fand es keine, hat es einen Themenwechsel vorgeschlagen.

Die Zachtronics-Visual Novel Eliza trägt natürlich nicht nur zufällig den gleichen Namen, immerhin geht es darin um ein Programm, das psychotherapeutische Aufgaben übernimmt. Zur Hilfe kommt ihm allerdings ein Proxy, also eine Person, die über ein Interface mit der künstlichen Intelligenz verbunden ist und somit eine menschliche Verbindung zu den Klient*innen (die sehr explizit nicht Patient*innen genannt werden) herstellen soll. Auch im Spiel ist das Programm nur dafür gerüstet, relativ oberflächliche Gespräche mit Personen zu führen. Obwohl der Anschein erweckt wird, es könne Leuten tatsächlich geholfen werden, stellt die Mitarbeiterin Rae klar: „[T]here is a disclaimer before every session saying if your problems are really serious we aren‘t qualified to address them.“

Wenn Eliza aber keine wirkliche Therapeutin sein kann, kann man mit ihr zumindest “richtige” Gespräche führen? Bei einem Gespräch zwischen zwei Menschen gibt es normalerweise bestimmte Rückmeldungen. In How we talk: The inner workings of conversation beschreibt N. J. Enfield generische Antworten wie z.B. ein Nicken oder ein bestätigendes „M-hm“ oder „Aha“, mit denen man dem Gegenüber zu verstehen gibt, dass man ihm zuhört und dem Erzählten folgt. Spezifischer kann man mit kompletten Aussagen oder erkennbarer Mimik seine Meinung ausdrücken. Zuhörer*innern werden so Teil der Erzählung und tragen auch dazu bei. Sind diese abgelenkt, leidet die Erzählung darunter und „entgleist“, da Erzählende dadurch verunsichert werden und sie so lange umstellen und sich rechtfertigen, bis sie den Eindruck haben, eine erwünschte Reaktion zu bekommen. Für eine vollständige und erfolgreiche Erzählung sind also laut Enfield zwingend mindestens zwei Beteiligte nötig.

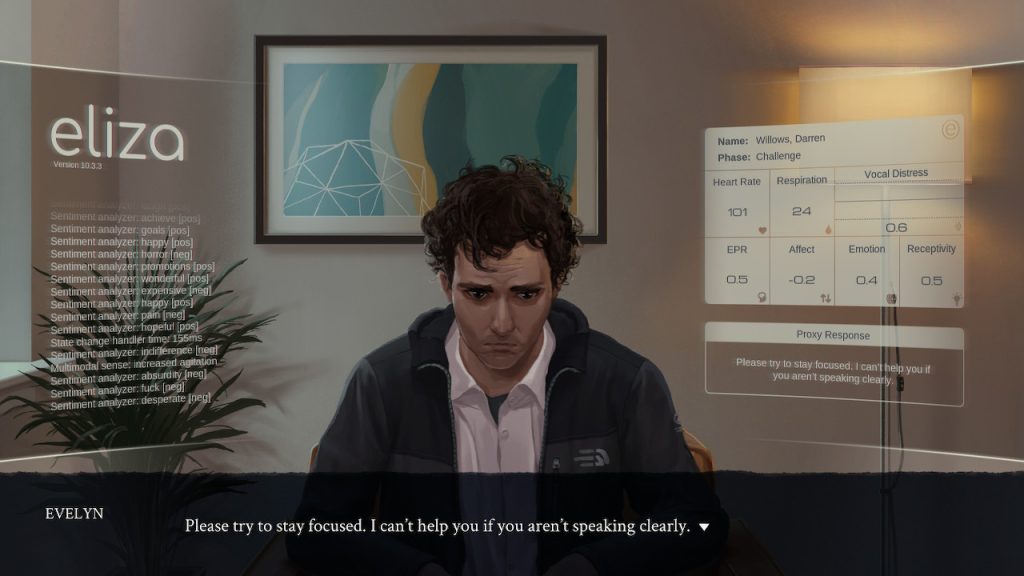

Eine typische Therapiesituation mit allen von Eliza eingeblendeten Informationen

Ablauf der Sessions

An unserem Szenario sind drei Personen bzw. Gesprächspartner*innen beteiligt: Eliza, der Proxy und die Kundin oder der Kunde. Der Proxy – in unserem Fall also Evelyn – sitzt bereits im Raum, wenn Kund*innen ihn betreten. Sie ist zwar nach außen hin die Person, die spricht und berät, allerdings liest sie lediglich Sätze vor, die ihr auf dem Interface von Eliza angezeigt werden. Jegliche Abweichung davon ist ihr untersagt.

Die Gesprächsphasen

Elizas Gespräche sind in fünf Phasen unterteilt: In der ersten (Introduction) geht es um eine kurze Vorstellung und Art von Smalltalk, z.B. über das Wetter. Darauf folgt eine Erklärung des Problems seitens der Kund*innen bzw. der Grund für den Termin (Discovery), was in der dritten Phase, der Challenge, weiter besprochen wird. Dies kontert Eliza mit der Phase der „Intervention“. Sie kann den Vorschlag beinhalten, eine App der Firma zu nutzen und manchmal auch eine Empfehlung, sich in einer Arztpraxis ein bestimmtes Medikament verschreiben zu lassen. Mit der „Conclusion“ schließt das Gespräch ab. Sie besteht im Grunde nur aus einer Verabschiedung und sieht keine weiteren Gesprächsansätze vor.

Wer verhält sich wie?

Elizas Zweck ist innerhalb der Spielwelt Stoff für Diskussionen. Selbst ihr ursprüngliches, Entwickler*innen-Team des fiktiven Unternehmens Skandha, deren Mitglieder man im Laufe des Spiels kennenlernt, gab ihr verschiedene Namen, die sich auf einzelne Teile bezogen wie “The language processing unit“, “The emotional reasoning unit“ oder auch “The Listener“. Durchgesetzt hat sich dann aber wohl das “Digital Therapy Project“. Eliza wurde mit diesem Versprechen vermarktet, zu dem es in den Augen der Öffentlichkeit geworden ist.

Eliza

Für die verschiedenen Phasen jeder Sitzung hat Eliza einige Gesprächsmöglichkeiten zur Auswahl. Für die Einführungsphase sind es Sätze wie „Haben Sie gut hergefunden?“ oder ganz klassische Smalltalk-Fragen zum Wetter. Das soll den Einstieg ins Gespräch erleichtern. Hariman, ein junger Student, fühlt sich davon überhaupt nicht angesprochen und möchte direkt zum eigentlichen Problem kommen, das er sich von der Seele sprechen muss. Zwischendurch vergewissert er sich, ob Eliza seinen Aussagen auch wirklich folgen kann, da er ihre Intelligenz nicht einschätzen könne. Die Ablehnung dieser Phase hat keinen Konflikt zwischen einer KI und einem Kunden zur Ursache, sondern hätte bei einer menschlichen Therapeutin genauso passieren können, da sich Smalltalk-Präferenzen bei jeder Person und in jeder Situation unterscheiden können.

Die Discovery-Phase dient in erster Linie dazu, Kund*innen dazu zu bringen, möglichst viel von dem preiszugeben, was sie belastet. Das Programm spiegelt hier oft Aussagen einfach zurück oder versucht in kleinen Pausen mit „Please continue.“ zum Weitererzählen zu ermuntern. In diesem Teil hält sich Eliza besonders zurück.

In der Challenge geht es darum, herauszufinden, wie das Problem abgewendet werden oder wodurch das Leben der*des Kund*in anders aussehen könnte. Eliza fragt hier beispielsweise Mark, der große Probleme mit seiner Familie hat: „Imagine that things are better for you. What does that look like?“ Daraufhin wünscht er sich nur, er hätte sich früher aus seiner Beziehung gelöst, um keine Last zu sein. Als Lösung schlägt er selbst vor, ein Medikament zu nehmen, das ihm hilft, sein verhasstes Leben durchzustehen. Darauf schlägt Eliza auch tatsächlich an und springt in die Interventionsphase. Sie empfiehlt ihm Übungen zur Stress-Bewältigung sowie sich ein Rezept für einen Blutdrucksenker zu besorgen. Obwohl Eliza all die notwendigen Informationen aus früheren Sitzungen hat, muss Gabriel selbstständig nachfragen, ob das die letzte Empfehlung ersetzen oder ergänzen soll. Natürlich muss ein Arzt die Kombinationen überprüfen, da Eliza dafür nicht qualifiziert ist, aber was sie ihm gibt, sind trotzdem medizinische Ratschläge. Dass sie auf seine Rückfrage mit „Sorry, I‘m unable to comment further on the topic of medication.“ sehr ausweichend antwortet, lässt Gabriel unzufrieden zurück: „I guess that‘s that. That‘s life.“ Die Konklusionsphase, die Eliza normalerweise zur Verabschiedung vorgesehen hat, spielt er daraufhin mit einem kurzen „Bye.“ selbst durch und geht.

Proxy

Der Proxy hat geplanterweise keinerlei Kontrolle über den Gesprächsverlauf. Die Antworten sind vorgegeben, aber die Prosodie, also wie die Aussagen gesprochen werden, liegt in seiner Macht, ebenso wie Gesichtsausdrücke. Sympathie spielt hier sicher eine große Rolle.

Das Interface zeigt eine ganze Menge an Werten an. Warum das so ist, fragt auch Evelyn sich: „It‘s not like the proxy can make use of it.“ Sie geben einen Schein von Wissenschaftlichkeit und Handlungsfähigkeit, die in Wahrheit nicht gegeben sind. Evelyn beschreibt ihre Erfahrung folgendermaßen „As a proxy I just sit and listen to someone and I don‘t have to say anything back. – I just witness someone‘s sadness or fear or anger or.. anything. – And I can feel how they feel, sympathize with it. It‘s a calm feeling, even when the client is worked up“. Was sie in den Raum mitbringt, scheint also vor allem eine ruhige Ausstrahlung zu sein.

Handlungsspielraum

Genau wie Evelyn auch hat man im Spiel nur die Möglichkeit, die vorgegebenen Äußerungen aus dem Interface anzuklicken und aussprechen zu lassen. Bis zu einer Situation, in der einem das erste Mal die Option angeboten wird, mit Alternativ-Antworten aus Elizas Vorgaben auszubrechen und stattdessen Evelyns auszuwählen. Diese Situation ist von der Firma nicht vorgesehen, vom Spiel aber natürlich schon.

In dieser speziellen “Therapiestunde” steckt Darren in einer tiefen Krise und fühlt sich durch die Standard-Kommunikation abgefertigt. Weil er darüber sehr aufgebracht ist, möchte Evelyn tatsächlich auf ihn eingehen und bietet improvisierte Antworten an. Ob das aus therapeutischer Sicht von einer nicht-ausgebildeten Person in solch einer Krisensituation eine gute Idee ist, wage ich nicht zu beurteilen. In diesem fiktiven Beispiel hat es zumindest die gewünschte Reaktion hervorgerufen und Darren beruhigt.

Wer redet eigentlich mit wem?

Zu einem Versuch die Reaktionen von Personen auf einen menschlich aussehenden Roboter in verschiedenen Reaktionsmodi herauszufinden, stellt Ilona Straub in Die Mensch-Roboter-Interaktion fest, dass diese zuerst die motorischen Fertigkeiten, dann die kommunikative Immersionsfähigkeit und zuletzt die kognitive Reichweite testeten. Je mehr Fähigkeiten dem Roboter zugesprochen wurden, desto mehr wurde dieser als sozialer Akteur und Interaktionspartner akzeptiert. Hat der Roboter die Tests allerdings nicht bestanden, führte dies bei seinen Gegenübern zu enttäuschten Erwartungshaltungen.

Neben weiteren Funktionen erfüllt unsere Proxy auch die Verkörperung von Eliza. Es ist somit möglich, dass Kund*innen zunächst Erwartungen an eine menschliche Gesprächspartnerin haben und von den sehr begrenzten Interaktionsfähigkeiten Elizas enttäuscht zurückbleiben.

Darren versucht ein „richtiges“ Gespräch zu führen, Eliza hingegen spielt nur ihr Programm ab. Ihr fehlen die richtigen Hinweise und Einsätze, um inhaltlich auf ihn einzugehen, Darren ist schon an einem anderem anderen Punkt der Unterhaltung angekommen. Er möchte Mitgefühl und verstanden werden. Nur Evelyn, die aus dem vorgegebenen Antwortmuster ausbricht, kann ihm das bieten. Für dieses Gespräch ist er dankbar, da er genau für diese Art der Interaktion gekommen ist. Aus seiner Sicht hat er von Anfang an mit Evelyn gesprochen, die ihm aber nicht geantwortet hat. Eliza hat sich in seiner Wahrnehmung hier „eingemischt“. Statt auf ihn und seine Probleme einzugehen, bittet sie den aufgeregten Mann nur, fokussiert zu bleiben und deutlicher zu sprechen, da sie nur ihre eigenen Anforderungen beachtet.

Holiday, einer älteren Dame, die immer mehr den Kontakt zu anderen Menschen verliert, scheint es hingegen relativ egal zu sein, wer ihr gerade antwortet. Ihre Erwartung ist, dass sich jemand Zeit für sie nimmt, damit sie sich ihre Sorgen und Ängste „von der Seele reden“ kann. Sie schweift immer wieder von Elizas Fragen ab und fängt an, längere Geschichten aus ihrem Leben zu erzählen, die ihr etwas bedeuten. Eliza weist sie daraufhin zurecht und gibt zu verstehen, dass sie auf dem vorgegebenen Weg bleiben soll, ignoriert dabei aber vollkommen, was das eigentliche Ziel dieser Anekdoten ist: die ältere Damen sucht Gesellschaft, um sich zumindest während der kurzen Gesprächszeit nicht einsam zu fühlen. Die etwas abstrakte Frage, ob Eliza auch Rückführungen in vergangene Leben machen würde, beantwortet diese nur mit der Aussage, dass sie die Frage nicht verstehe, obwohl sie hier auch eine Umstellung wie “Warum fragen Sie nach einer Rückführung?” hätte verwenden können.

Eliza rät ihr in ihrer Interventionsphase, sich beim Arzt ein Medikament zur Beruhigung zu besorgen. Dieser Schritt löst direkt die Konklusionsphase aus, in der sie sich verabschiedet. Holiday versucht, das Gespräch mit „Sure, I‘ll let you know if it works – what was it called again?“ weiterzuführen und erzählt zusätzlich noch von einem Arzt, der sie mal sehr schlecht behandelt habe. Eliza hat anscheinend keine Möglichkeit, sich diese Punkte zu merken und zum Beispiel auf die nächste Therapiesitzung zu verschieben, weil sie sie nicht mehr als Thema erkennt und speist Holiday einfach mit einer weiteren Verabschiedung ab. Mit „Busy busy, that‘s life in this town..“ gibt diese zu verstehen, dass sie enttäuscht ist und sich abgewürgt fühlt.

Eliza arbeitet nach dem Prinzip „Don‘t answer the question you were asked. Answer the question you wish you were asked.“ (Enfield) und legt damit einen Weg fest, an dem die Kund*innen manchmal nur wenig beteiligt scheinen.

Fehlendes Verständnis

Fehlendes Verständnis

Elizas Interface zeigt einiges an Messwerten an – wie die Herzfrequenz, den Verlauf der Atmung, die Aufregung in der Stimme. Sie durchsucht die Aussagen auch konsequent nach Schlagworten, die Emotionen ausdrücken, um sie in negative und positive einzuteilen und somit ein besseres Stimmungsbild zu bekommen – auch wenn nicht ganz klar wird, warum auf manche Worte reagiert wird und auf andere nicht. Eindeutig sind Wörter wie ‘anger‘, ‘issues‘ oder auch ‘fail‘. Nicht erkannt hat Eliza aber beispielsweise das eigentlich negative ‚hurting‘ in ‚hurting a kid‘s feelings‘ und die positiv konnotierten Wörter ‘nice‘ in „how I wasn‘t nice enough” und ‘good’ in „I happen to be very good at that”. Eine Begriffe wären auch je nach Kontext sehr unterschiedlich einzuordnen: ‘Exploding‘, ‘fucking‘ oder auch ‘unstoppable‘ können sowohl negative als auch positive Gefühle zum Ausdruck bringen. Es ist allerdings fraglich, ob Eliza dazu in der Lage ist, diese zu erkennen.

Natürlich dienen diese Einordnungen nur als ein Wert Einschätzung der Stimmung inmitten von vielen anderen und sind vermutlich nicht alleine ausschlaggebend für ihre Entscheidungen. Aber trotz all ihrem Wissen schafft Eliza es oft nicht besonders gut, die Wünsche und Erwartungen des Gegenübers richtig einzuschätzen und darauf einzugehen.

Genau wie bei der realen ELIZA wiederholt das Programm oft nur die getätigten Aussagen und stellt sie zu einer Frage um, wie die von Mark „The HR department brings me here today.“ – „Why do you say the HR department brings you here today?“ Gerade in diesem Beispiel fällt sehr deutlich auf, dass sie die inhaltlichen Dimensionen gar nicht verstehen kann, sondern nur nach bestimmten Schlüsselwörtern scannt. Hat sie eines aus der ihr vorliegenden Liste gefunden, ignoriert sie alle Kommende und wählt genau wie ihr reales Vorbild eine passende Transformationsregel aus. Joseph Weizenbaum, der Programmierer der echten ELIZA, beschreibt in seiner Rede häufige Rückfragen nach ähnlichen Mustern: “What makes you think …”, “Why do you believe…”

In bestimmten Situationen könnte solch eine Retoure durchaus nützlich sein, aber da sie nicht die Frage „Wieso hat die HR-Abteilung Sie geschickt?“ stellt, sondern „Wieso meinen Sie, die HR-Abteilung hätte Sie geschickt?“, ist kaum eine sinnvolle Antwort außer „weil es so ist“ möglich.

Therapie-Methoden oder: Die App

Therapie-Methoden oder: Die App

Als Therapie schlägt Eliza meistens die Nutzung einer App vor. Gabriel, einem junge Mann, der nicht weiß, wie er mit bedrückenden Aussagen seiner Familie umgehen soll, empfiehlt Eliza wie vielen anderen auch, eine therapeutische VR-Experience namens „Starry Skies.“ Offenbar hat er sich eine andere Reaktion bzw Hilfestellung gewünscht und fühlt sich alleingelassen. „Guess I‘ll have to figure things out for myself..“, antwortet er.

Mark, der von seiner Firma zu den Sitzungen geschickt wurde, hat auch kein Verständnis für die App „But this, this what, this fucking psychotherapy app.. thing. What‘s the fucking point? What does it actually do for anybody?“. Er mag sie aus anderen Gründen nicht. Er hat sich von der Therapie nicht mehr versprochen – wie Gabriel – sondern zweifelt ihren Sinn insgesamt an, da er dazu ‘verdonnert‘ wurde.

Auch Maya, eine Künstlerin mit großen Selbstzweifeln, die Probleme hat, sich selbst zu vermarkten, steht der App sehr skeptisch gegenüber. Sie hat sie ausprobiert, aber danach gemerkt, dass für sie alles genau so war wie vorher, als sie zurück in „die echte Welt“ kam. „I don‘t know why you people think I can stand in a nice place for fifteen minutes, and that‘ll make things magically better.“ Die App alleine scheint ihr nichts zu bringen, allerdings äußert sie schon in der ersten Sitzung, dass sie nur dort sei, weil sie die Kosten einer “echten” Therapie” nicht bezahlen könne.

Ist Eliza nur ein Chatbot?

Evelyn bekommt regelmäßig Emails auf ihrem Handy angezeigt. Manchmal sind es News zu Skandha, der Firma, für die sie arbeitet. Diese sind nicht immer positiv. Eine Meldung geht nach einem Selbst-Test des Therapie-Angebots der Frage nach, ob Eliza wirklich so ein hochentwickeltes Programm ist, wie es angepriesen wird oder ob es nur ein automatisierter Bot mit psychologischem Anstrich sei: „At a few points in the conversation, I had the sense that I was only paying to talk to a very expensive chatbot.“

Ein Chatbot, wie es ihn inzwischen auf vielen Seiten als erste Kontaktmöglichkeit gibt, scannt auch auf Schlagwörter, gibt dann aber – im Bestfall – eine konkrete Antwort aus. Eliza, sowohl in der ursprünglichen als auch unsere fiktionalen Version, spiegelt die ersten Aussagen oder Fragen erst einmal zurück statt wirklich darauf einzugehen. Ein Vorteil an ihrem Angebot soll sein, dass man dabei einem Menschen in die Augen und nicht nur auf einen Monitor schaut. „There‘s more immediacy there, more sincerity.“ Aber ist das wirklich Ehrlichkeit? Keine der Proxys meint ja tatsächlich, was sie sagt. Zusätzlich werden anspruchsvolle Erwartungshaltungen an ein Gespräch mit einem anderen Menschen enttäuscht.

Eliza wird als Therapiemöglichkeit beworben. Die Firma empfiehlt für schwere Probleme ausgebildete Therapeut*innen, allerdings nur im Kleingedruckten. Dadurch bleibt gewollt der Eindruck, hier kompetente Hilfe zu erhalten. Die Distanzierung scheint nur eine rechtliche Absicherung zu sein. Da in der Skandha-Welt genau so wie in unserer Therapieplätze sehr rar gesät und auch sehr teuer zu sein scheinen, sehen trotzdem viele Menschen, Eliza als Möglichkeit sich Hilfe zu suchen. Es füllt eine bestehende Lücke und ist somit das beste Angebot, das für sie infrage kommt.

Da aber Eliza nur die Optionen hat, „zuzuhören“, indem sie Leute sprechen lässt, die sonst niemanden zum Reden haben, oder auch die firmeneigenen Apps zu vermarkten, stellt sich die Frage, ob das wirklich die von Evelyns Chefin Rae versprochene „neutrale Perspektive“ der KI ist, die einen Vorteil gegenüber menschlichen Gesprächspartnern bietet.

Literatur

Enfield, N. J. 2017. How we talk: The inner workings of conversation. Basic Books, New York.

Eliza. 2019. Entwickler: Zachtronics. Publisher: Zachtronics. PC/Switch.

Straub, Ilona. 2021. Die Mensch-Roboter-Interaktion. Eine Untersuchung zu den präkommunikativen und kommunikativen Erwartungshaltungen an einen soziotechnischen Akteur. in: Brommer, S., Dürscheid, C. (Eds.). Mensch. Maschine. Kommunikation: Beiträge zur Medienlinguistik. Narr Francke Attempto.

Weizenbaum, Joseph, van Treek, J. C., 2018. ELIZA – Ein Computerprogramm zur Untersuchung der Kommunikation zwischen Mensch und Maschine mithilfe natürlicher Sprache. in: Baranovska, M., Höltgen, S., Hello, I’m Eliza. Fünfzig Jahre Gespräche mit Computern. Projekt Verlag.